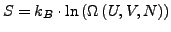

Next: Die statistische Entropie von

Up: Statistische Begründung der Entropie

Previous: Qualitatives Bild

Contents

Index

Entropie nach Shannon

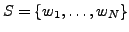

- Gegeben

- sind

unterscheidbare Zustände

unterscheidbare Zustände

mit den Wahrscheinlichkeiten

mit den Wahrscheinlichkeiten

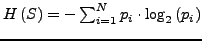

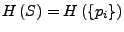

- Informationsmangel - Entropie

-

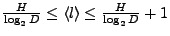

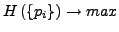

- Optimale Kodierung

-

-

ist die mittlere Länge der Kodierung

der

ist die mittlere Länge der Kodierung

der

Zustände über einem Alphabet mit

Zustände über einem Alphabet mit  Zeichen

Zeichen

- Dies beschreibt ein Intervall in dem die optimale Kodierung liegen

muss

- Die Huffmann - Kodierung erfüllt ist eine solche optimale Kodierung

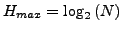

- Eigenschaften

- der shannonschen Entropie

-

-

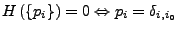

für

für

mit

mit

-

-

invariant unter Permutation

der

invariant unter Permutation

der

Marco Möller 18:12:17 18.05.2006